Gar nicht. Wofür gibt es denn Fibre Channel? Die gibts gewiss auch in 2-3 Meter LängeMaverickM schrieb:Und wie willst Du den dann ins Rack packen!?

Manche haben Vorstellungen...

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

News Ultrastar Transporter: 368 TB NVMe-Speicher werden im Koffer transportiert

- Ersteller MichaG

- Erstellt am

- Zur News: Ultrastar Transporter: 368 TB NVMe-Speicher werden im Koffer transportiert

massaker

Lt. Commander

- Registriert

- Mai 2012

- Beiträge

- 1.790

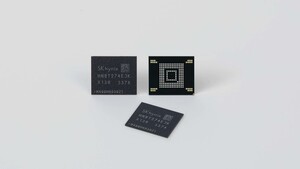

Ganz genau, das Teil hat 24x WD SN650 15.36TB drin:the_pi_man schrieb:Was'n das für ein krummer Speicherwert? 368 TB

368 TB : 16 TB = 23 NVMe's

Ah, sehe gerade die 16 TB NVMe haben nur 15,36 TB.. dann passt es mit 24 Stück.

Nun, WD hat leider selbst keine größere im Angebot. Würden sie auf Micron oder Solidigm setzen (24x 30,72 TB!), dann wäre auch die doppelte Kapazität locker möglich. Und wenn man bedenkt, dass die 61,44 TB von Solidigm so langsam verfügbar sind, dann sogar die vierfache

Vindoriel

Admiral

- Registriert

- Sep. 2014

- Beiträge

- 7.422

Wäre dann XGS-PON, nur dass Du diese mit 63 anderen Anschlüssen teilst.Radde schrieb:Bei der Deutschen Glasfaser gehört der symmetrische 10Gbit-Anschluss schon seit Jahren zu den Standardtarifen für Business-Kunden. Leider sind solche Tarife trotzdem sehr teuer und die Leitung wird natürlich am Alltag dimensioniert und nicht an einer einmaligen Datenübertragung.

PrefoX

Cadet 2nd Year

- Registriert

- März 2019

- Beiträge

- 26

schneller wie? also genauso schnell? wie bedeutet =, als bedeutet != (ungleich)iGameKudan schrieb:

wie kann etwas schneller wie sein?

Zuletzt bearbeitet von einem Moderator:

thelittledevil

Ensign

- Registriert

- Jan. 2009

- Beiträge

- 185

Wieviel müsste mannin die hanf mehmen, um sowasminmllein nach zu bauen?

Gibt es Boards mit bifurcation auf mehreren x16 slots?

Mit 4x 4er 2280 karten, könnte man relativ preisgünstig 64TB brutto realisieren.

Als interface wäre für mich aber TB4 aber besser?

Mit 24 von diesen boards könnte man das viel kompakter realisieren:

https://www.friendlyelec.com/index.php?route=product/product&product_id=294

96x 4TB m.2 SSD. Lan wird halt spannend aus 24x2,5G 100G zu machen. In der kategorie gibt es irgenwie nix. Müssten dann 10G ports sein

https://geizhals.de/mikrotik-cloud-...26-4c-20g-2q-rm-a3147311.html?hloc=at&hloc=de

40G würde gehen

16x 16 TB = 256 TB brutto

Boards 1600 eur

SSDs 13000 eur

Router und netzwerkzub 1000 eur

Netzteil und case 1000 eur

= unter 17k eur

Was kksten die 384 TB?

Gibt es Boards mit bifurcation auf mehreren x16 slots?

Mit 4x 4er 2280 karten, könnte man relativ preisgünstig 64TB brutto realisieren.

Als interface wäre für mich aber TB4 aber besser?

Mit 24 von diesen boards könnte man das viel kompakter realisieren:

https://www.friendlyelec.com/index.php?route=product/product&product_id=294

96x 4TB m.2 SSD. Lan wird halt spannend aus 24x2,5G 100G zu machen. In der kategorie gibt es irgenwie nix. Müssten dann 10G ports sein

https://geizhals.de/mikrotik-cloud-...26-4c-20g-2q-rm-a3147311.html?hloc=at&hloc=de

40G würde gehen

16x 16 TB = 256 TB brutto

Boards 1600 eur

SSDs 13000 eur

Router und netzwerkzub 1000 eur

Netzteil und case 1000 eur

= unter 17k eur

Was kksten die 384 TB?

Zuletzt bearbeitet:

Epyc + HyperX und gib ihm. Gebraucht recht günstig zu realisieren, brauchst ja keine gullgonen Kerne.

Hatte ich mal hier gebaut mit 12 NVMe und nem Epyc 7282, allerdings nur 28TB: 4x4TB, 4x2TB, 4x1TB. Angebunden per 100Gbit NIC. Warum? Wofür? Weils geht. Darum.

Inzwischen sind die HyperX aber in verschiedene Systeme gewandert.

Hatte ich mal hier gebaut mit 12 NVMe und nem Epyc 7282, allerdings nur 28TB: 4x4TB, 4x2TB, 4x1TB. Angebunden per 100Gbit NIC. Warum? Wofür? Weils geht. Darum.

Inzwischen sind die HyperX aber in verschiedene Systeme gewandert.

Zuletzt bearbeitet:

Vindoriel

Admiral

- Registriert

- Sep. 2014

- Beiträge

- 7.422

Also das glaube ich Dir garantiert nicht. DSL 768k (und 2000k war im Kommen) war da schon üblich und zu Anfang war Steam auch nur für Spiele von Valve und diese passten auch auf 2 CDs (Half-Life, CS 1.6...). Und 2005, als Steam auch für andere Spielehersteller geöffnet wurde, gab es noch schnellere DSL-Anschlüsse. USB-Sticks waren zu der Zeit auch schon wesentlich größer als DVDs.iGameKudan schrieb:Zu geil, das erinnert mich an damalige Zeiten, wo ich für Zockerkumpels Spiele auf Steam gedownloadet habe, die Backup-Files (nein, keine Raubkopien, sondern die Steam-Sicherungsdateien) auf DVD gebrannt und denen dann die DVDs per Post geschickt habe, weils schneller ging wie die Spiele über deren Leitung herunterzuladen.

beckenrandschwi

Lt. Commander

- Registriert

- Aug. 2004

- Beiträge

- 1.947

Hehe, so exotisch und neu es aussehen mag, aber es wurde schon vor Jahrzehnten gesagt:

"Unterschätze nie die Bandbreite eines mit Magnetbändern voll beladenen LKW, der da über

die Autobahn braust."

"Unterschätze nie die Bandbreite eines mit Magnetbändern voll beladenen LKW, der da über

die Autobahn braust."

ThirdLife

Commander

- Registriert

- Aug. 2019

- Beiträge

- 2.680

2x 200Gbits. QSFP56 wohl.Haldi schrieb:Anhang anzeigen 1473916

Sehe ich das richtig das in der PCI-E Karte da zwei 400Gbits Ports stecken?

What ? Natürlich gibts das. 10Gbit gehen über Kupfer mit Cat 6a bis zu 100m. Nutzen wir für normale Backupserver als NICTeam völlig problemlos, lediglich ESXi Hosts werden via FC SAN angebunden.Haldi schrieb:Server mit 10Gbit RJ45 gibt es eh keine.

Wird bei uns auch so laufen (800 Mann Firma) wenn wir einen weiteren Backup Colo Standort aufbauen. Lokal am Stammsitz einbauen, Daten syncen, ausbauen, hinfahren, vor Ort einbauen, Daily Sync einschalten, Bierchen am See trinken gehen.Dr. MaRV schrieb:Nicht nur Google, auch ein großer Autobauer hat von mir vor etlichen Jahren in einigen seiner Außenwerke in Deutschland je eine FAS2620 mit DS460c (mit 72 x 10 TB bestückt, 12 intern, 60 im Shelf) aufgebaut bekommen. Nach dem Syncen haben sie das System abgebaut und im Stammwerk wieder aufgebaut.

Zuletzt bearbeitet:

eastcoast_pete

Lt. Commander

- Registriert

- Juni 2020

- Beiträge

- 1.235

Ich sehe den Sinn von sowas in Situationen, in denen sofort Daten (zB 8K Videos von Aufnahmen "draußen") sichern will. Wobei es hier mehr als genug genug Platz für stundenlange RAW Dateien von mehreren 8K Kameras hat, und noch einiges mehr.

Und , etwas weniger schön: So ein Koffer ist auch optimal zum Datenklau vor Ort geeignet, v.a. wenn eine Anlage oder Firma tatsächlich ihre sensitiven Daten vollständig vom Internet abgekoppelt hat, und hacken nicht so leicht geht. Nimmt natürlich an, man kommt direkt an das interne Netzwerk ran. Dann allerdings passen ja dann alle Design Dateien, Test Ergebnisse und sonstige Unterlagen locker rein.

Ob der GRU schon bestellt hat (durch Strohmänner, natürlich)😁?

Und , etwas weniger schön: So ein Koffer ist auch optimal zum Datenklau vor Ort geeignet, v.a. wenn eine Anlage oder Firma tatsächlich ihre sensitiven Daten vollständig vom Internet abgekoppelt hat, und hacken nicht so leicht geht. Nimmt natürlich an, man kommt direkt an das interne Netzwerk ran. Dann allerdings passen ja dann alle Design Dateien, Test Ergebnisse und sonstige Unterlagen locker rein.

Ob der GRU schon bestellt hat (durch Strohmänner, natürlich)😁?

eastcoast_pete

Lt. Commander

- Registriert

- Juni 2020

- Beiträge

- 1.235

Angenommen, man kann 200 Gbit tatsächlich zu 100 % nutzen, sind das theoretische 25 GB/s (theoretisch, praktisch kriegt man fast immer deutlich weniger). Wenn man ~ 20 GB/s durchgehend schafft, dann sind's (x 3600) 72 TB in einer Stunde. Also, eine kurze Nacht direkt am (allerdings sehr schnellen) Network Switch gehangen, und voll ist er, der Koffer.MaverickM schrieb:@Zer0DEV

Und wie lange glaubst du braucht es um 384TB zu befüllen, selbst mit der 200gbit Anbindung!?

Ich würde da keinen Blade Server einfach so im Gang stehen lassen wollen...

ThirdLife

Commander

- Registriert

- Aug. 2019

- Beiträge

- 2.680

Auch immer angenommen das Storage / die Hosts geben das überhaupt her. 200Gbits ist wirklich oberstes Enterprise Segment und selbst da hab ich deutlich lahmere Hardware oft im Einsatz gesehen.eastcoast_pete schrieb:Also, eine kurze Nacht direkt am (allerdings sehr schnellen) Network Switch gehangen, und voll ist er, der Koffer.

Ich denke WD hat das einfach so dimensioniert, damit ihr Storage zumindest nicht das Bottleneck darstellt, nicht weil die erwarten, dass jeder Kunde hier mit 2-400 Gbits draufballert.

Relak

Lt. Junior Grade

- Registriert

- Juni 2020

- Beiträge

- 438

PS828 schrieb:bin sehr oft zu einem kumpel mit einer SSD gefahren, hab meine spiele oder files heruntergeladen

Schön dass ich nicht der einzige war der sowas gemacht hat. Was für Zeiten damals... damals sind gerade mal 6 Jahre. #Neuland

iGameKudan schrieb:dann die DVDs per Post geschickt habe, weils schneller ging wie die Spiele über deren Leitung herunterzuladen.

MVP!

Radde

Commodore

- Registriert

- Apr. 2008

- Beiträge

- 4.226

Nur weil es schnelle Anschlüsse gab heißt es doch nicht, dass niemand mehr mit ISDN im Internet war?Vindoriel schrieb:Also das glaube ich Dir garantiert nicht. DSL 768k (und 2000k war im Kommen) war da schon üblich und zu Anfang war Steam auch nur für Spiele von Valve und diese passten auch auf 2 CDs (Half-Life, CS 1.6...). Und 2005, als Steam auch für andere Spielehersteller geöffnet wurde, gab es noch schnellere DSL-Anschlüsse.

Nur weil heute das Gigabit möglich ist und 100Mbit/s "üblich" gibt es noch genug Leute mit 16Mbit/s und weniger.

Die Realität ist leider eine Aneinanderreihung von Einzelfällen...

MaverickM

20k Fleet Admiral

- Registriert

- Juni 2001

- Beiträge

- 23.595

eastcoast_pete schrieb:Angenommen, man kann 200 Gbit tatsächlich zu 100 % nutzen

Es sind knapp 4,3h. Also länger, als ich so einen Blade Server, der mindestens im 5, wahrscheinlich eher 6-stelligen Bereich liegt, einfach irgendwo im Gang stehen lassen will. Mal davon abgesehen, dass das Ding ja auch Stromversorgung braucht, idealerweise von einer USV etc.

Ähnliche Themen

- Antworten

- 21

- Aufrufe

- 2.307

- Antworten

- 33

- Aufrufe

- 8.463

- Antworten

- 64

- Aufrufe

- 15.349

- Antworten

- 35

- Aufrufe

- 6.156

- Antworten

- 15

- Aufrufe

- 4.350